Was ist der Unterschied zwischen Spark und Scala?

Share

Share

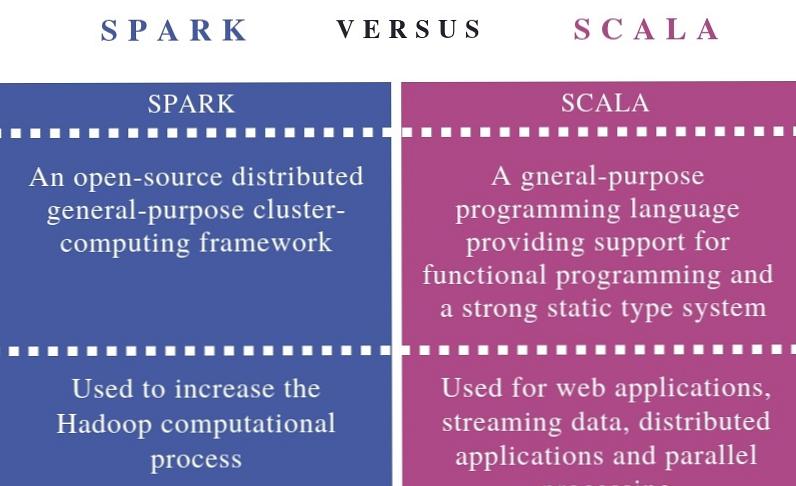

Das Hauptunterschied zwischen Spark und Scala liegt das Apache Spark ist ein Cluster-Computing-Framework, das für schnelle Hadoop-Berechnungen entwickelt wurde, während Scala eine universelle Programmiersprache ist, die funktionale und objektorientierte Programmierung unterstützt.

Apache Spark ist ein Open Source-Framework für die Ausführung umfangreicher Datenanalyseanwendungen auf gruppierten Computern. Es kann sowohl Batch- als auch Echtzeit-Analyse- und Datenverarbeitungs-Workloads verarbeiten. Auf der anderen Seite ist Scala eine Programmiersprache. Es wird kompiliert und auf Java Virtual Machine (JVM) ausgeführt. Scala verbessert die Produktivität, Anwendungsskalierbarkeit und Zuverlässigkeit. Kurz gesagt, Scala wird als die Hauptsprache für die Interaktion mit der Spark-Core-Engine angesehen.

Wichtige Bereiche

1. Was ist Spark?

- Definition, Funktionalität

2. Was ist Scala?

- Definition, Funktionalität

3. Welche Beziehung besteht zwischen Spark und Scala?

- Gliederung der Vereinigung

4. Was ist der Unterschied zwischen Spark und Scala?

- Vergleich der wichtigsten Unterschiede

Schlüsselbegriffe

Datenanalyse, Spark, Programmiersprachen, Scala

Was ist Spark?

Spark wurde von der Apache Software Foundation eingeführt, um den Hadoop-Berechnungsprozess zu verbessern. Es besteht aus In-Memory-Cluster-Computing, um die Verarbeitungsgeschwindigkeit in einer Anwendung zu erhöhen. Spark basiert auf Hadoop MapReduce und erweitert das MapReduce-Modell, um mehrere Berechnungen durchzuführen. Dazu gehört auch eine interaktive Abfrage.

Spark bietet mehrere Vorteile. Dadurch kann eine Anwendung im Hadoop-Cluster viel schneller ausgeführt werden als im Arbeitsspeicher und auf der Festplatte. Es reduziert auch die Anzahl der Lese- und Schreibvorgänge auf der Festplatte. Es unterstützt verschiedene Programmiersprachen. Es verfügt über integrierte APIs in Java, Python und Scala, sodass der Programmierer die Anwendung in verschiedenen Sprachen schreiben kann. Darüber hinaus bietet es Unterstützung für Streaming-Daten, Grafiken und maschinelles Lernen, um erweiterte Datenanalysen durchzuführen.

Was ist Scala?

Scala ist eine hybride funktionale Programmiersprache. Es verfügt über Funktionen der objektorientierten Programmierung und der funktionalen Programmierung. Als objektorientierte Programmiersprache betrachtet sie jeden Wert als Objekt. Die Unterklassen können Klassen erweitern. Darüber hinaus gibt es eine mischungsbasierte Zusammensetzung für die Vererbung. Als funktionale Programmiersprache definiert es anonyme Funktionen, unterstützt Funktionen höherer Ordnung und verschachtelte Funktionen.

Scala ist statisch geschrieben. Der Programmierer muss in den meisten Fällen keinen Typ angeben. Ähnlich wie Java wird der Scala-Quellcode in Bytecode konvertiert. Dieser Bytecode wird von der Java Virtual Machine (JVM) ausgeführt. Ein Programmierer kann einfacher von Java zu Scala wechseln und umgekehrt. Scala kann Java-Code ausführen. Es ermöglicht die Verwendung von Java SDK-Klassen und der benutzerdefinierten Java-Klassen. Darüber hinaus unterstützt Scala die gleichzeitige und synchronisierte Verarbeitung.

Beziehung zwischen Spark und Scala

- Mit Scala können Daten mit Spark analysiert werden.

- Mit anderen Worten, Scala ist eine Sprache, in der Spark geschrieben wird.

Unterschied zwischen Spark und Scala

Definition

Spark ist ein verteiltes Open-Source-Cluster-Computing-Framework für allgemeine Zwecke. Scala ist eine universelle Programmiersprache, die Unterstützung für die Funktionsprogrammierung und ein starkes statisches Typsystem bietet. Dies ist also der grundlegende Unterschied zwischen Spark und Scala.

Verwendungszweck

Spark wird verwendet, um den Hadoop-Berechnungsprozess zu erhöhen. Scala kann für Webanwendungen, Streaming-Daten, verteilte Anwendungen und Parallelverarbeitung verwendet werden. Daher ist dies auch ein wichtiger Unterschied zwischen Spark und Scala.

Fazit

Der Unterschied zwischen Spark und Scala besteht darin, dass Apache Spark ein Cluster-Computing-Framework ist, das für eine schnelle Hadoop-Berechnung konzipiert ist, während die Scala eine universelle Programmiersprache ist, die funktionale und objektorientierte Programmierung unterstützt. Scala ist eine Sprache, in der Spark geschrieben wird.

Referenz:

1. "Einführung in Apache Spark". Www.tutorialspoint.com, Tutorials Point, Verfügbar hier.

2. „Scala-Übersicht“. Www.tutorialspoint.com, Tutorials Point, erhältlich hier.

3. „Was ist Scala-Programmierung - Ein Vergleich zwischen Scala und Java.“ Intellipaat, 2. Juni 2018, hier verfügbar.

Bildhöflichkeit:

1. "Spark Java Logo" Von David Åse - Eigene Arbeit (CC BY-SA 4.0) über Commons Wikimedia

2. “Ј2” von École Polytechnique Fédérale de Lausanne (EPFL) - (Public Domain) über Commons Wikimedia